Un terminal con un diseño espectacular,que saldra el próximo año con el que siemens intentara quitarle protagonismo al iphone de apple.Este aparatp integra una gran variedad de funciones, y su tamaño lo hace muy manegable.

.

Un terminal con un diseño espectacular,que saldra el próximo año con el que siemens intentara quitarle protagonismo al iphone de apple.Este aparatp integra una gran variedad de funciones, y su tamaño lo hace muy manegable.

.

TELÉFONOS MÓVILES Y CÁNCER DE CEREBRO

Por ahora, los resultados de un estudio realizado por la Fundación para la Salud de Estados Unidos y el Memorial Sloan-Kettering Cancer Center de Nueva York darán tranquilidad a los usuarios de teléfonos celulares: su uso moderado y a mediano plazo no está relacionado con cáncer de cerebro.

En los Estados Unidos utilizan este elemento más de 86 millones de habitantes, en tanto que hay 16.500 casos anuales de ese tipo de cáncer. El estudio fue realizado sobre 891 personas de 18 a 80 años, 469 diagnosticados de cáncer cerebral y 422 sin el problema, todos usuarios de telefonía celular. Los pacientes enfermos utilizaban el aparato 2,5 horas mensuales, en tanto que los sanos lo hacían 2,2.

El doctor Mark Malkin, neurooncólogo del Memorial Sloan, reconoció que el estudio se limita a la telefonía analógica pero indica que la digital, más reciente, podría arrojar datos diferentes, debido a los campos de radiofrecuencia. Además, el trabajo se realizó sobre personas que usaron celulares solamente durante 2 o 3 años.

HISTORIA DEL TELAR MECÁNICO

El telar es una máquina utilizada para fabricar tejidos con hilo u otras fibras. Un tejido fabricado con un telar se produce entrelazando dos conjuntos de hilos dispuestos en ángulo recto. Los hilos longitudinales se llaman urdimbre, y los hilos transversales se denominan trama.

El telar manual se remonta a la era antigua y se utilizó en las civilizaciones chinas y de Oriente Próximo antes de alcanzar Europa. Su uso está muy extendido en los países en vías de desarrollo y en los países industrializados se utiliza también para tejer telas artesanales que se usan en decoración.

El primer paso en la mecanización del telar fue la lanzadera volante, patentada en 1733 por el inventor británico John Kay. Consistía en un mecanismo de palancas que empujaba la lanzadera por una pista. La lanzadera volante aumentó considerablemente la velocidad de tejido y permitía que una sola persona pudiera realizar el picado.

El telar mecanizado fue perfeccionado por otro inventor británico, Edmund Cartwrigh, quien patentó el primer telar mecánico en 1786. En los años que siguieron, él y otros ingenieros hicieron algunas mejoras y, a principios del siglo XIX, el telar mecánico se utilizaba ampliamente. Aunque es en esencia parecido al telar manual, este tipo de telar cuenta con algunos elementos adicionales, como mecanismos para detener el telar si la trama o la urdimbre se rompen o si la lanzadera no alcanza el final de su recorrido. Otros dispositivos permiten intercambiar las lanzaderas sin necesidad de detener el funcionamiento del telar. En uno de los extremos del telar se encuentra un cargador con varias bobinas llenas de hilo. El telar cuenta con un mecanismo para expulsar las bobinas vacías y tomar una nueva.

Hoy en día el telar mecánico convencional se considera arcaico e ineficaz, por lo que se han desarrollado otros tipos de telares en los que se intenta eliminar la lanzadera. Se conocen como telares sin lanzadera. Entre ellos se encuentra un sistema suizo que reemplaza la lanzadera con un dardo. En lugar de transportar su propia carga de hilo, el dardo lo toma de un paquete de gran tamaño y lo arrastra a través del hueco. Otro tipo importante de telar sin lanzadera es el telar de chorro, que utiliza un chorro de aire o agua a alta presión para empujar el hilo de trama de un lado a otro, con lo que se evita utilizar dispositivos mecánicos. Estos telares permiten insertar hasta 1.500 hilos de trama por minuto. Muchas fabricas de tejidos utilizan telares sin lanzadera porque suelen ser más silenciosos y más rápidos que los telares convencionales.

PARTES Y FUNCIONAMIENTO DE UN TELAR MECÁNICO

EN LA IMAGEN SE REPRESENTA UN TELAR MECANICO QUE COMPRENDE UNA MAQUINA (1), UNA DISPOSICION DE INTERCAMBIO (2), UNA DISPOSICION DE SOPORTE (3) Y UNA DISPOSICION PARA LA MANIPULACION DE HILOS DE TRAMA (6). LA DISPOSICION DE INTERCAMBIO COMPRENDE UN APOYO POSTERIOR DEL TELAR, UNA UNIDAD DE MONITORIZACION DE TRAMA (38), UNA DISPOSICION DE SUJECION DEL LIZO Y UNA BOBINA, Y ESTA ACOPLADA A LA MAQUINA (1) O A LA DISPOSICION DE SOPORTE (3), DE FORMA QUE LA DISPOSICION DE INTERCAMBIO CON LOS LIZOS, LA BOBINA Y EL ELEMENTO DE REMETIDO PODRAN REEMPLAZARSE COMO UNA UNIDAD DE ALMACENAMIENTO. LA CONEXION ENTRE LA DISPOSICION DE INTERCAMBIO (2) Y LA DISPOSICION 8PARA EL APORTE DE HILOS DE TRAMA (6) A LA UNIDAD DE INTERCAMBIO (31) CONSTITUYE UN SISTEMA ADICIONAL DE INTERCAMBIO DE ELEMENTOS. DEBIDO A DICHOS SISTEMAS DIFERENTES DE INTERCAMBIOS, EL INTERCAMBIO DE ELEMENTOS ES SUSTANCIALMENTE MAS SIMPLE Y SE REALIZA EN UN TIEMPO MENOR.

Para solucionar vuestras dudas preguntar aquí este blog actualmente está inactivo.

ENERGIA NUCLEAR

Se llama energía nuclear a aquella que se obtiene al aprovechar las reacciones nucleares espontáneas o provocadas por el ser humano. Estas reacciones se dan en algunos isotopos de ciertos elementos químicos, siendo el más conocido de este tipo de energía la fisión del uranio-235, con la que funcionan los reactores nucleares. Sin embargo, para producir este tipo de energía aprovechando reacciones nucleares pueden ser utilizados muchos otros isotopos de varios elementos químicos, como el torio, el plutonio, el estroncio o el polonio.

Los dos sistemas con los que puede obtenerse energía nuclear de forma masiva son la fisión nuclear y la fusión nuclear. La energía nuclear puede transformarse de forma descontrolada, dando lugar al armamento nuclear; o controlada en reactores nucleares en los que se produce energía eléctrica, energía mecánica o energía térmica. Tanto los materiales usados como el diseño de las instalaciones son completamente diferentes en cada caso.

Otra técnica, empleada principalmente en pilas de enorme duración para sistemas que requieren poco consumo eléctrico, es la utilización de generadores termoeléctricos de radio isotopos (GTR, o RTG en inglés), en los que se aprovechan los distintos modos de desintegración para generar electricidad en sistemas de termopares a partir del calor transferido por una fuente radioactiva.

La energía desprendida en esos procesos nucleares suele aparecer en forma de partículas subatómicas en movimiento. Esas partículas, al frenarse en la materia que las rodea, producen energía térmica. Esta energía térmica se transforma en energía mecánica utilizando motores de combustión externa, como las turbinas de vapor. Dicha energía mecánica puede ser empleada en el transporte, como por ejemplo en los buques nucleares; o para la generación de energía eléctrica en centrales nucleares.

La principal característica de este tipo de energía es la alta cantidad de energía que puede producirse por unidad de masa de material utilizado en comparación con cualquier otro tipo de energía conocida por el ser humano.

REACCIONES NUCLEARES

En 1896 Becquerel descubrió que algunos elementos químicos emitían radiaciones. Tanto él como Marie Curie y otros estudiaron sus propiedades, descubriendo que estas radiaciones eran diferentes de los ya conocidos Rayos X y que poseían propiedades distintas, denominando a los tres tipos que consiguieron descubrir alfa, beta y gamma.

Pronto se vio que todas ellas provenían del núcleo atómico que describió Rutherford en 1911.

Con el uso del neutrino , partícula descrita teóricamente en 1930 por Pauli pero no medida hasta 1956 por Clyde Cowan y sus colaboradores, se pudo explicar la radiación beta.

En 1932 James Chadwick descubrió la existencia del neutrón que Wolfgang Pauli había predicho en 1930, e inmediatamente después Enrico Fermi descubrió que ciertas radiaciones emitidas en fenómenos no muy comunes de desintegración eran en realidad estos neutrones.

En 1934 Fermi se encontraba en un experimento bombardeando núcleos de uranio con estos neutrones recién descubiertos, midiendo nuevas formas de «radiaciones». En 1938, en Alemania, Lise Meitner, Otto Hahn y Fritz Strassmann verificaron los experimentos de Fermi. Es más, en 1939 demostraron que parte de los productos que aparecían al llevar a cabo estos experimentos eran núcleos de bario. Muy pronto llegaron a la conclusión de que eran resultado de la división de los núcleos del uranio. Se había llevado a cabo el descubrimiento de la fisión.

En Francia, Joliot Curie descubrió que además del bario, se emitían neutrones secundarios en esa reacción, haciendo factible la reacción en cadena.

También en 1932 Mark Oliphant teorizó sobre la fusión de núcleos ligeros (de hidrógeno), describiendo poco después Hans Bethe el funcionamiento de las estrellas basándose en este mecanismo.

Hay dos tipos de reacciones nucleares:

–La fisión:

En plena Segunda Guerra Mundial, los militares alemanes descubrieron el potencial que estos fenómenos podrían suponer y comenzaron a desarrollar una bomba basada en la fisión: La bomba nuclear. Albert Einstein, en 1939, firmó una carta a Franklin Delano Roosvelt, presidente de los Estados Unidos, escrita por Leó Szilárd, en la que se prevenía sobre este hecho.

El 2 de diciembre de 1942, como parte del proyecto Manhattan dirigido por J. Robert Oppenheimer, se construyó el primer reactor del mundo hecho por el ser humano (existió un reactor natural en Oklo): el Chicago Pile-1 (CP-1).

Como parte del mismo programa militar, se construyó un reactor mucho mayor en Hanford, destinado a la producción de plutonio, y al mismo tiempo, un proyecto de enriquecimiento de uranio en cascada. El 16 de julio de 1945 fue probada la primera bomba nuclear (nombre en clave Trinity) en el desierto de Álamo gordo. En esta prueba se llevó a cabo una explosión equivalente a 19.000.000 de kg de TNT (19 kilotones), una potencia jamás observada anteriormente en ningún otro explosivo.

Ambos proyectos desarrollados finalizaron con la construcción de dos bombas, una de uranio enriquecido y una de plutonio (Little Boy y Fat Man) que fueron lanzadas sobre las ciudades japonesas de Hiroshima (6 de agosto de 1945) y Nagasaki (9 de agosto de 1945) respectivamente. El 15 de agosto de 1945 acabó la segunda guerra mundial en el Pacífico con la rendición de Japón. Por su parte el programa de armamento nuclear alemán (liderado este por Werner Heisenberg), no alcanzó su meta antes de la rendición de Alemania el 8 de mayo de 1945. Posteriormente se llevaron a cabo programas nucleares en la Unión Soviética (primera prueba de una bomba de fisión el 29 de agosto de 1949), Francia y Gran Bretaña, comenzando la carrera armamentística en ambos bloques creados tras la guerra, alcanzando límites de potencia destructiva nunca antes sospechada por el ser humano (cada bando podía derrotar y destruir varias veces a todos sus enemigos).

Ya en la década de 1940, el almirante Hyman Rickover propuso la construcción de reactores de fisión no encaminados esta vez a la fabricación de material para bomba, sino a la generación de electricidad. Estos reactores, se pensó (acertadamente) que podrían constituir un gran sustituto del diésel en los submarinos. Se construyó el primer reactor de prueba en 1953, botando el primer submarino nuclear (el USS Nautilus (SSN-571)) el 17 de enero de 1955 a las 11:00. El Departamento de Defensa Estadounidense propuso el diseño y construcción de un reactor nuclear utilizable para la generación eléctrica y propulsión en los submarinos a dos empresas distintas norteamericanas: General Electric y Westinghouse. Estas empresas desarrollaron los reactores de agua ligera tipo BWR y PWR respectivamente.

Estos reactores se han utilizado para la propulsión de buques, tanto de uso militar (submarinos, cruceros, portaaviones,…) como civil (rompehielos y cargueros), donde presentan potencia, reducción del tamaño de los motores, reducción en el almacenamiento de combustible y autonomía no mejorados por ninguna otra técnica existente.

Los mismos diseños de reactores de fisión se trasladaron a diseños comerciales para la generación de electricidad. Los únicos cambios producidos en el diseño con el transcurso del tiempo fueron un aumento de las medidas de seguridad, una mayor eficiencia termodinámica, un aumento de potencia y el uso de las nuevas tecnologías que fueron apareciendo.

Entre 1950 y 1960 Canadá desarrolló un nuevo tipo, basado en el PWR, que utilizaba agua pesada como moderador y uranio natural como combustible, en lugar del uranio enriquecido utilizado por los diseños de agua ligera. Otros diseños de reactores para su uso comercial utilizaron carbono (Magnox, AGR, RBMK o PBR entre otros) o sales fundidas (litio o berilio entre otros) como moderador. Este último tipo de reactor fue parte del diseño del primer avión bombardero (1954) con propulsión nuclear (el US Aircraft Reactor Experiment o ARE). Este diseño se abandonó tras el desarrollo de los misiles balísticos intercontinentales (ICBM).

Otros países (Francia, Italia, Argentina entre otros) desarrollaron sus propios diseños de reactores nucleares para la generación eléctrica comercial.

En 1946 se construyó el primer reactor de neutrones rápidos (Clementine) en Los Álamos, con plutonio como combustible y mercurio como refrigerante. En 1951 se construyó el EBR-I, el primer reactor rápido con el que se consiguió generar electricidad. En 1996, el Superfenix o SPX, fue el reactor rápido de mayor potencia construido hasta el momento (1200 MWe). En este tipo de reactores se pueden utilizar como combustible los radioisótopos del plutonio, el torio y el uranio que no son fisibles con neutrones térmicos (lentos).

En la década de los 50 Ernest Lawrence propuso la posibilidad de utilizar reactores nucleares con geometrías inferiores a la criticidad (reactores subcríticos cuyo combustible podría ser el torio), en los que la reacción sería soportada por un aporte externo de neutrones. En 1993 Carlo Rubbia propone utilizar una instalación de espalación en la que un acelerador de protones produjera los neutrones necesarios para mantener la instalación. A este tipo de sistemas se les conoce como Sistemas asistidos por aceleradores (en inglés Accelerator driven systems, ADS sus siglas en inglés), y se prevé que la primera planta de este tipo (MYRRHA) comience su funcionamiento entre el 2016 y el 2018 en el centro de Mol (Bélgica).

-La fusión

Ya en los años 1940, como parte del proyecto Manhatan se estudió la posibilidad del uso de la fusión en la bomba nuclear. En 1.942 se investigó la posibilidad del uso de una reacción de fisión como método de ignición para la principal reacción de fusión, sabiendo que podría resultar en una potencia miles de veces superior. Sin embargo, tras finalizar la Segunda Guerra Mundial , el desarrollo de una bomba de estas características no fue considerado primordial hasta la explosión de la primera bomba atómica rusa en 1949, RDS-1 o Joe-1. Este evento provocó que en 1950 el presidente estadounidense Harry S. Truman anunciara el comienzo de un proyecto que desarrollara la bomba de hidrógeno. El 1 de noviembre de 1952 se probó la primera bomba nuclear (nombre en clave Mike, parte de la Operación Hiedra), con una potencia equivalente a 10.400.000.000 de kg de TNT (10,4 megatones). El 12 de agosto de 1953 la Unión Soviética realiza su primera prueba con un artefacto termonuclear (su potencia alcanzó algunos centenares de kilotones).

Las condiciones que eran necesarias para alcanzar la ignición de un reactor de fusión controlado, sin embargo, no fueron derivadas hasta 1955 por John D. Lawson Los criterios de Lawson definieron las condiciones mínimas necesarias de tiempo, densidad y temperatura que debía alcanzar el combustible nuclear (núcleos de hidrógeno) para que la reacción de fusión se mantuviera. Sin embargo, ya en 1946 se patentó el primer diseño de reactor termonuclear. En 1951 comenzó el programa de fusión de Estados Unidos, sobre la base del Stellarator En el mismo año comenzó en la Unión Soviética el desarrollo del primer Tocamak, dando lugar a sus primeros experimentos en 1956. Este último diseño logró en 1968 la primera reacción termonuclear cuasi estacionaria jamás conseguida, demostrándose que era el diseño más eficiente conseguido hasta la época. ITER el diseño internacional que tiene fecha de comienzo de sus operaciones en el año 2016 y que intentará resolver los problemas existentes para conseguir un reactor de fusión de confinamiento magnético, utiliza este diseño.

En 1962 se propuso otra técnica para alcanzar la fusión basada en el uso de láseres para conseguir una implosión en pequeñas cápsulas llenas de combustible nuclear (de nuevo núcleos de hidrógeno). Sin embargo hasta la década de los 70 no se desarrollaron láseres suficientemente potentes. Sus inconvenientes prácticos hicieron de esta una opción secundaria para alcanzar el objetivo de un reactor de fusión. Sin embargo, debido a los tratados internacionales que prohibían la realización de ensayos nucleares en la atmósfera, esta opción (básicamente microexplosiones termonucleares) se convirtió en un excelente laboratorio de ensayos para los militares, con lo que consiguió financiación para su continuación. Así se han construido el National Ignition Facility (NIF, con inicio de sus pruebas programadas para 2010) estadounidense y el Láser Megajoule (LMJ, que será completado en el 2010) francés, que persiguen el mismo objetivo de conseguir un dispositivo que consiga mantener la reacción de fusión a partir de este diseño. Ninguno de los proyectos de investigación actualmente en marcha predicen una ganancia de energía significativa, por lo que está previsto un proyecto posterior que pudiera dar lugar a los primeros reactores de fusión comerciales (DEMO para el confinamiento magnético e HIPER para el confinamiento inercial).

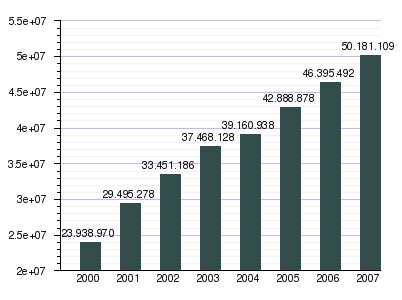

En España se ha incrementado el numero de altas de telefonía móvil en los ultimos años.En el siguiente gráfico podemos ver su considerable aumento desde el año 2000 hasta el 2007.

La evolución del teléfono móvil ha permitido disminuir su tamaño y peso, desde el Motorola DynaTAC, el primer teléfono móvil en 1983 que pesaba 780 gramos, a los actuales más compactos y con mayores prestaciones de servicio. El desarrollo de baterías más pequeñas y de mayor duración, pantallas más nítidas y de colores, la incorporación de software más amigable, hacen del teléfono móvil un elemento muy apreciado en la vida moderna.

El avance de la tecnología ha hecho que estos aparatos incorporen funciones que no hace mucho parecían futuristas, como juegos, reproducción de musica MP3 y otros formatos, correo electrónico, SMS, agenda electrónica PDA, fotografía digital y video digital, videollamada, navegación por Internet y hasta Televisión digital. Las compañías de telefonía móvil ya están pensando nuevas aplicaciones para este pequeño aparato que nos acompaña a todas partes. Algunas de esas ideas son: medio de pago, localizador e identificador de personas. Siempre hay que tener en cuenta los grandes avances sufridos desde el primer teléfono móvil hasta el actual.

Este vídeo nos muestra la evolución de la telefonía móvil desde 1985-hasta hoy y hace que nos hagamos una idea de la diferencia entre los moviles del pasado con los actuales.

DEFINICIÓN:

Una locomotora de vapor es una locomotora impulsada por la acción del vapor de agua. Las locomotoras de vapor fueron la forma dominante de tracción en los ferrocarriles hasta que a mediados del siglo XX fueron reemplazadas por las locomotoras diesel y eléctricas.

Una locomotora de vapor es una locomotora impulsada por la acción del vapor de agua. Las locomotoras de vapor fueron la forma dominante de tracción en los ferrocarriles hasta que a mediados del siglo XX fueron reemplazadas por las locomotoras diesel y eléctricas.

ORIGEN:

Los primeros ferrocarriles empleaban caballerías para arrastrar carros sobre rieles. Cuando se desarrollaron las máquinas de vapor, se trató de aplicarlas al ferrocarril. Los primeros intentos tuvieron lugar en Gran Bretaña; así, por ejemplo, Richard Trevithick construyó una locomotora en 1804. Esta maquina tenía un solo cilindro, disponía de un volante de inercia y la transmisión de fuerza a las ruedas se realizaba por engranajes. La no incorporación al ferrocarril de la locomotora de Trevithick fue que los railes de hierro fundido no aguantaron el peso de la maquina. Se realizaron tres viajes de prueba en las minas de hierro de Penydarren al Canal Methry-Cardiff, quedando los railes dañados en estos ensayos. Se continuó utilizando la fuerza animal para el arrastre de los vagones, más adelante se vuelve la mirada otra vez en las locomotoras ya que debido a las guerras Napoleónicas los caballos escasean y su adquisición se encarece. En 1811 John Blenkinsop patenta el sistema de cremallera para locomotora, finalmente en 1812 Matthew Murray diseña y construye la locomotora «The Salamamanca» en los talleres Feton, Murray and Wood, la locomotora dispone por primera vez dos cilindros y monta el sistema de cremallera patentado por John Blenkinsop, solucionando el problema de peso de la maquina, si la locomotora se realizaba con poco peso no tenia suficiente adherencia, sus ruedas motrices patinaban y no conseguía arrastrar la carga, si por el contrario la maquina aumentaba de peso para mejorar la adherencia, dañaba los railes. «the Salamanca» solucionaba estos inconvenientes.

FORMA BÁSICA:

La locomotora de vapor típica emplea una caldera horizontal cilíndrica con el hogar en la parte posterior, parcialmente dentro de la cabina que protege a los operarios de las inclemencias meteorológicas. El hogar es el lugar donde se quema el combustible. Está formado por cuatro paredes laterales y un techo al que se denomina cielo. En la base se encuentra la parrilla o quemador, sobre el que se deposita el combustible, y bajo la parrilla, una caja para recoger las cenizas o cenicero y la boca por la que entra el aire para la combustión. Los humos del hogar salen por una serie de tubos situados longitudinalmente dentro de la caldera y rodeados de agua, a la que transmiten el calor. El conjunto de tubos se denomina haz tubular, y algunos de mayor diámetro contienen en su interior otros más finos por los que discurre vapor para ser recalentado y aumentar así la potencia de la locomotora. En la parte frontal de la caldera se encuentra la caja de humos, a donde va a parar el humo tras haber pasado por los tubos del haz, antes de salir por la chimenea, que sobresale en la parte superior. El vapor se recoge en la parte más alta de la caldera, bien sea a través de un tubo perforado, situado por encima del nivel del agua, o bien en un domo (cúpula en la parte superior). El vapor sale de la caldera a través de una válvula reguladora, conocida también como «regulador».Cuando el regulador está abierto, el vapor se dirige por el tubo de admisión al motor. Allí entra en primer lugar en la denominada caja del vapor o capilla de la distribución, donde una pieza móvil, la corredera, al deslizarse alternativamente a uno y otro lado, hace que el vapor se dirija, a su vez, alternativamente a uno y otro lado del pistón dentro del cilindro del vapor, en el que entra a través de las lumbreras de admisión y tras expandirse, la propia corredera lo dirige hacia la lumbrera de escape. Esto ocasiona un movimiento alternativo de vaivén del pistón, a uno y otro lado, que acciona así la rueda motriz principal a través de una barra, también llamada vástago del pistón, que se articula con el pie de biela. Esta biela va conectada en el otro extremo a una clavija excéntrica en la rueda motriz principal, a la que hace girar mediante un movimiento de manivela. La corredera, auténtica válvula de distribución del vapor en el motor, se acciona a través de un conjunto de barras articuladas: el mecanismo de accionamiento de la distribución del vapor, que es ajustable para controlar el sentido de la marcha y el corte de la admisión. El punto de corte de la admisión del vapor determina durante qué proporción del recorrido del pistón se admite vapor dentro del cilindro. Así, por ejemplo, un punto de corte al 50% indica que se admite vapor sólo durante la mitad del recorrido del pistón. Durante el resto del recorrido, el pistón resulta impulsado por la fuerza expansiva del vapor que quedó dentro del cilindro. Un uso inteligente del corte de la admisión ahorra vapor y, por lo tanto, también combustible y agua. El corte de la admisión se controla desde la cabina por medio de la palanca inversora, que también sirve para cambiar el sentido de la marcha y que desempeña, en cierto modo, una función análoga a la palanca de cambios de un automóvil.

El vapor que escapa del cilindro después de haber impulsado el pistón, va a la caja de humos, donde se libera a través de una boquilla o tobera enfocada a la chimenea, por donde sale junto con el humo, creando un vacío al salir, que favorece el tiro del hogar. Las ráfagas sucesivas del vapor de escape son las que producen el característico sonido «chuf, chuf» de las locomotoras de vapor. Una locomotora de vapor posee normalmente dos cilindros, uno a cada lado. Las hay también que disponen de tres y de cuatro. Los cilindros actúan por parejas, existiendo un desfase de 90 grados entre el accionamiento de la rueda motriz de un lado y su homóloga del lado opuesto, proporcionando cuatro golpes de potencia en cada revolución de las ruedas. Las ruedas de la tracción están conectadas en cada lado por barras de conexión o de acoplamiento que transmiten la fuerza desde la rueda motriz principal a las otras ruedas motrices, a las que también se denomina ruedas acopladas. En las de tres cilindros, uno de ellos va en posición central, bajo la caldera, y su biela acciona uno de los ejes motrices, que ha de tener forma de cigüeñal.

La caldera descansa sobre un armazón denominado bastidor o chasis, en el que se montan también los cilindros y que a su vez descansa sobre los ejes. Los ejes motrices se montan sobre cojinetes que pueden desplazarse arriba y abajo en el bastidor. Están conectados a él por medio de ballestas o, menos frecuentemente, por suspensiones de muelles, que permiten a los ejes cierto grado de movimiento independiente para suavizar el efecto de los altibajos de la vía. Muchas locomotoras tienen carretones de cabeza o de cola denominados bojes, que son unos ensamblados de dos ejes y cuatro ruedas con su propio chasis y suspensión, que soportan el cuerpo principal de un vagón o una locomotora en cada uno de sus extremos, y permiten un cierto grado de rotación en torno a un eje vertical, para facilitar así el tránsito del vagón o locomotora por las curvas.

Cuando el boje está formado por un solo eje, se denomina bisel, porque su invención se atribuye al norteamericano Levi Bissell en 1857. En las locomotoras de talla mediana se utilizó un bisel delantero y en las más grandes un boje de dos ejes. En la parte trasera era más frecuente montar un bisel que un boje porque dejaba más espacio para el cenicero.

La mayoría de las locomotoras van acopladas a un ténder, que transporta el agua y el combustible; pero otras llevan el combustible y el agua directamente en la propia máquina, llamadas locomotoras tanque, por los prominentes tanques para el agua en la parte superior o más comúnmente en los costados de la caldera.esta agua de los tanques es llevada a la caldera mediante un Flujo en tubería que permite recircular el agua del tanque a la caldera .

Desde sus comienzos, el combustible predominante fue el carbón, aunque también se usó la madera en zonas rurales y en empresas madereras. El bagazo que queda después de extraer el jugo de la caña de azúcar se empleó en las empresas dedicadas al cultivo y obtención del azúcar de caña. Cuando el petróleo comenzó a utilizarse de forma habitual, se empleó el fuel oil en las locomotoras de algunas zonas.

Una locomotora de vapor se maneja con un equipo de al menos dos personas. Una, el maquinista, que es responsable de controlar la locomotora y el tren en su conjunto; la otra, el fogonero, responsable del fuego, la presión y el agua.

La telegrafía es el conjunto de sistemas de comunicación a distancia de mensajes gráficos y escritos según un código de transmisión predefinido. Desde este punto de vista, se pueden considerar como sistemas telegráficos las formas de comunicación a distancia empleados desde la prehistoria, como los tambores, las hogueras, las señales luminosas o los códigos navales de banderas.

Los primeros equipos eléctricos para transmisión telegráfica fueron inventados por el norteamericano Samuel F. B. Morse en 1837, y por el físico inglés sir Charles Wheatstone en colaboración con el ingeniero sir William F. Cooke.

El código básico, llamado código Morse, transmitía mensajes mediante impulsos eléctricos que circulaban por un único cable. El aparato de Morse, que emitió el primer telegrama público en 1844, tenía forma de conmutador eléctrico. Mediante la presión de los dedos, permitía el paso de la corriente durante un lapso determinado y a continuación la anulaba. El receptor Morse original disponía de un puntero controlado electro-magnéticamente que dibujaba trazos en una cinta de papel que giraba sobre un cilindro. Los trazos tenían una longitud dependiente de la duración de la corriente eléctrica que circulaba por los cables del electroimán y presentaban el aspecto de puntos y rayas.

En el transcurso de los experimentos con dicho instrumento, Morse descubrió que las señales sólo podían transmitirse correctamente a unos 32 km. Más allá las señales se hacían demasiado débiles como para poder registrarlas. Morse y sus colaboradores desarrollaron un aparato de relés que podía acoplarse a la línea telegráfica a unos 32 km de la estación emisora de señales a fin de repetirlas automáticamente y enviarlas a otros 32 km más allá. El relé estaba formado por un conmutador accionado por un electroimán. El impulso que llegaba a la bobina del imán hacía girar un armazón que cerraba un circuito independiente alimentado por una batería. Este mecanismo lanzaba un impulso potente de corriente a la línea, que a su vez accionaba otros relés hasta alcanzar el receptor. Algunos años después de que Morse hubiera desarrollado su equipo receptor y lo hubiera exhibido de forma satisfactoria, los operadores telegráficos descubrieron que resultaba posible diferenciar entre los puntos y las rayas por el simple sonido, cayendo en desuso el aparato de registro de Morse. Sin embargo, los demás principios básicos del sistema Morse siguieron utilizándose en los circuitos de telegrafía por hilo.

Dado que la telegrafía resultaba demasiado costosa para poder implantarla con carácter universal, se desarrollaron diferentes métodos para enviar varios mensajes simultáneamente por una misma línea. En la telegrafía dúplex, el primer avance de este tipo, se puede transmitir un mensaje simultáneo en ambas direcciones entre dos estaciones. En la telegrafía cuádruplex, inventada en 1874 por Thomas Edison, se transmitían dos mensajes simultáneamente en cada dirección. En 1915 se implantó la telegrafía múltiple que permitía el envío simultáneo de ocho o más mensajes. Ésta y la aparición de las máquinas de teletipo, a mediados de los años veinte, hizo que se fuera abandonando progresivamente el sistema telegráfico manual de Morse de claves y que se sustituyera por métodos alámbricos e inalámbricos de transmisión por ondas.Los vídeos de Vodpod ya no están disponibles.

Evolución del telégrafo:

Orientación electrónica

El Global Positioning System, más conocido como GPS, es un sistema de localización que se ha puesto de moda en las diferentes actividades de aire libre (deportivas o de otra índole) en las que hay que desplazarse de un punto a otro por terreno más o menos desconocido. Uno de los campos en los que su uso puede ser de gran utilidad es el de la bicicleta de montaña. Todo el mundo conoce a algún compañero de club o de ruta que lleve ese «cacharrillo» en el manillar cuando la ruta no es muy conocida.

El Global Positioning System, más conocido como GPS, es un sistema de localización que se ha puesto de moda en las diferentes actividades de aire libre (deportivas o de otra índole) en las que hay que desplazarse de un punto a otro por terreno más o menos desconocido. Uno de los campos en los que su uso puede ser de gran utilidad es el de la bicicleta de montaña. Todo el mundo conoce a algún compañero de club o de ruta que lleve ese «cacharrillo» en el manillar cuando la ruta no es muy conocida.

El GPS ya tiene, como tal sistema de posicionamiento, más de 20 años, ya que los técnicos del Departamento de Defensa de los Estados Unidos (DoD, Department of Defense) lo crearon a primeros de los años 70, aprovechando una red de satélites que habían lanzado al espacio. De todas formas no ha sido hasta finales de los 80 cuando se ha podido utilizar el GPS de forma «civil», al decidir el DoD la creación de una señal «abierta» a unos receptores de uso publico, diferentes de las que ellos siguen utilizando.

| ¿Cómo funciona el GPS? |

Actualmente hay una gran cantidad de satélites girando alrededor de la tierra, de diversos orígenes y con distintas funciones. De todos ellos, 27 de los enviados por Estados Unidos tienen como función principal enviar continuamente una serie de señales que indican la órbita y posición exacta de cada uno de los satélites con respecto a un centro de operaciones situado en Estados Unidos.

Actualmente hay una gran cantidad de satélites girando alrededor de la tierra, de diversos orígenes y con distintas funciones. De todos ellos, 27 de los enviados por Estados Unidos tienen como función principal enviar continuamente una serie de señales que indican la órbita y posición exacta de cada uno de los satélites con respecto a un centro de operaciones situado en Estados Unidos.

El papel de un receptor GPS no es otro que decodificar estas señales en algo que sea legible por el usuario de dicho aparato, que en nuestro caso serán coordenadas, (latitud / longitud) y altitud, además de otros datos como la hora y el día. Cuando nuestro receptor GPS recibe la señal de cuatro de estos satélites (tres son necesarios para los cálculos de posición y un cuarto para ajustar el tiempo) es capaz de situar con gran exactitud el lugar en que nos encontramos. Por lo general, en espacio abierto, el GPS puede captar la señal de bastantes más de cuatro satélites, con lo que se mejora de manera notable la precisión de la posición que obtenemos. En los casos más favorables, podemos llegar a obtener una precisión de alrededor de 5 m en horizontal y algo más en vertical.

Para que nuestro receptor sea capaz de darnos esta información sobre la posición, es necesario que sepa en cada momento y de manera muy exacta dónde está cada satélite, así como una extraordinaria precisión en la medición del tiempo. Explicar cómo lo hace queda fuera del alcance de este artículo, pero si tienes interés puedes ir a este artículo en La Página Española del GPS, donde lo explican muy claramente.

| ¿Para qué sirve un GPS? |

Lo primero que hay que tener en cuenta es que el receptor GPS no es una brújula (aunque puede funcionar como si lo fuera). Las primeras veces que se utiliza este aparato electrónico, todos tendemos a usarlo como si lo que marca fuera el Norte magnético. Lo que el receptor GPS nos señala son las coordenadas de nuestra posición actual, que deberíamos trasladar a un mapa para conocer dónde nos encontramos, pero también dispone de la opción de marcar el rumbo hacia un punto de destino, siempre que le hayamos introducido correctamente las coordenadas de este último. Para que nos indique en qué sentido hemos de marchar (brújula de movimiento) tendremos que comenzar a desplazarnos, ya que esta posibilidad solamente funciona cuando estamos en movimiento, no en parado.

Pero ¿para qué sirve realmente? Pues principalmente para cuatro cosas:

| GPS – ¿Cómo utilizarlo? |

| Ya hemos comentado que un receptor GPS nos va a dar las coordenadas y la altura del punto en que nos encontramos. Esto puede resultar de utilidad en situaciones de falta de relieve y por tanto de puntos de referencia válidos (por poner un ejemplo cercano, en las llanuras manchegas y castellanas) o en caso de estar perdidos en la niebla, en terreno desconocido y sin haber tomado referencias anteriores. Por lo demás, con una brújula y un altímetro bien utilizados se pueden cubrir el resto de los casos: viendo dos puntos de referencia identificables sobre el mapa, la tarea no es muy complicada, aunque con un GPS será sin duda mucho más rápida y precisa.Pero la mejor utilización de este aparato la encontramos, si nos gusta la cartografía, a la hora de marcar rutas. Introduciendo en el aparato las coordenadas de los distintos puntos de paso o waypoint , que serán aquellos en los que cambiemos el rumbo (la dirección) ostensiblemente (cruces, collados, etc), o cualquier otra cosa de interés que deseamos resaltar para otras ocasiones, para volver por ahí otro día o bien para verlo desde casa más adelante. Un waypoint puede ser un lugar donde hemos encontrado setas durante varias temporadas seguidas, una fuente en un camino, un cruce que todavía no hemos explorado y quiero ver en el mapa, o un punto que queremos mandar a un amigo por e-mail.Un conjunto de waypoints pueden juntarse de tal forma que den lugar a una ruta. Las rutas nos sirven para navegar en línea recta de un waypoint a otro, y cuando llegamos a éste el GPS nos indica el rumbo a tomar para llegar al siguiente. Las rutas se crean fácil y rápidamente, sobre todo en el ordenador, pero la mayor desventaja que presentan para la bici es que son una sucesión de tramos rectos. Están pensadas fundamentalmente para la navegación aérea o acuática, donde no hay caminos marcados, no obstáculos en medio como rios, montañas o barrancos.El tercer tipo de «elementos» que nos van a ayudar a la navegación son los tracks. Un track no es más que una sucesión de puntos, una especie de «miguitas de pan de Pulgarcito» que nos van a ir dibujando el camino. El track, al contrario que la ruta, va siguiendo los recovecos y curvas del camino. Por ello suelen ser los más utilizados para marcar e intercambiar rutas de bici. El GPS nos graba el track según vamos avanzando, y posteriormente podemos guardarlo y pasárselo a algún amigo. Pero a la inversa, también podemos introducirle el track (que nos han pasado o hemos dibujado sobre el mapa con el ordenador) e ir siguiéndolo con la misma facilidad que seguiríamos una línea pintada en el suelo. |

| Ventajas e inconvenientes |

|

|

Empezando por lo segundo, y circunscribiéndonos al ámbito del ciclismo, el primer inconveniente es que un GPS es algo más caro que una brújula y un altímetro. Por supuesto, para sacarle todo su provecho hay que saber leer un mapa y conocer la terminología de la orientación: rumbo, latitud, longitud… y esto para algunos es un gran inconveniente. Otra desventaja es su relativamente alto consumo eléctrico, con lo que las baterías recargables se convierten en un extra imprescindible si no queremos «arruinarnos» y contaminar con las pilas alcalinas. Hacerse con unas buenas pilas recargables (las hay ya de 2300 mAh) y un buen cargador será hoy por hoy una gran inversión complementaria al receptor GPS.

Entre las ventajas para los que practicamos el deporte de las dos ruedas, el GPS resulta muchísimo más exacto y rápido que la brújula, y nos da la posición incluso cuando no tenemos referencias visuales. Además sus funciones de memoria nos permiten grabar y recuperar posteriormente los datos (las coordenadas de los distintos puntos de paso, tracks, rutas, etc.) una vez en casa, pudiendo archivarlos para su uso posterior o compartirlos con otra gente.

Se estima que son necesarios unos 2.000 millones de dólares para actualizar la red de satélites

El Gobierno estadounidense ha emitido un informe en el que alerta de que el GPS, que se ha hecho imprescindible en muchos aspectos de la vida diaria, puede comenzar a fallar el año que viene debido a la falta de fondos. Este estudio estima que son necesarios unos 2.000 millones de dólares (1.460 millones de euros) para actualizar la red de satélites que hacen posible el funcionamiento de los navegadores que muchos ciudadanos llevan en el coche.

Por lo visto, el Ejército del Aire estadounidense, responsable de la gestión de la red de satélites, ha descuidado sus tareas, señala el informe, elaborado por la Oficina de Responsabilidad Gubernamental, que advierte de que «existe una alta probabilidad de que la red caiga por debajo del número de satélites requeridos para proveer el nivel de servicio al que el Gobierno de Estados Unidos se ha comprometido».

En la actualidad, la red dispone de entre 24 y 32 satélites en órbita alrededor de la Tierra y son necesarios al menos cuatro para localizar un punto determinado. Aunque en teoría podría seguir funcionando con menos de 24 satélites, los expertos alertan de que la precisión del sistema se reduciría notablemente.

Para el ciudadano de a pie esto supondría no obtener resultados tan exactos cuando busca un restaurante o una calle. Sin embargo, en el caso de la aviación comercial, que opera con un margen de precisión del 99,9%, la más mínima imprecisión podría tener graves consecuencias.

Una hipotética falta de precisión del GPS beneficiaría al sistema europeo Galileo, desarrollado por la Unión Europea (UE) y la Agencia Espacial Europea (ESA) para competir con el modelo norteamericano. Cuando Galileo empiece a funcionar -se espera que lo haga en 2011- tendrá un margen de error de sólo cuatro metros en horizontal y menos de ocho en vertical, prácticamente la décima parte del GPS.